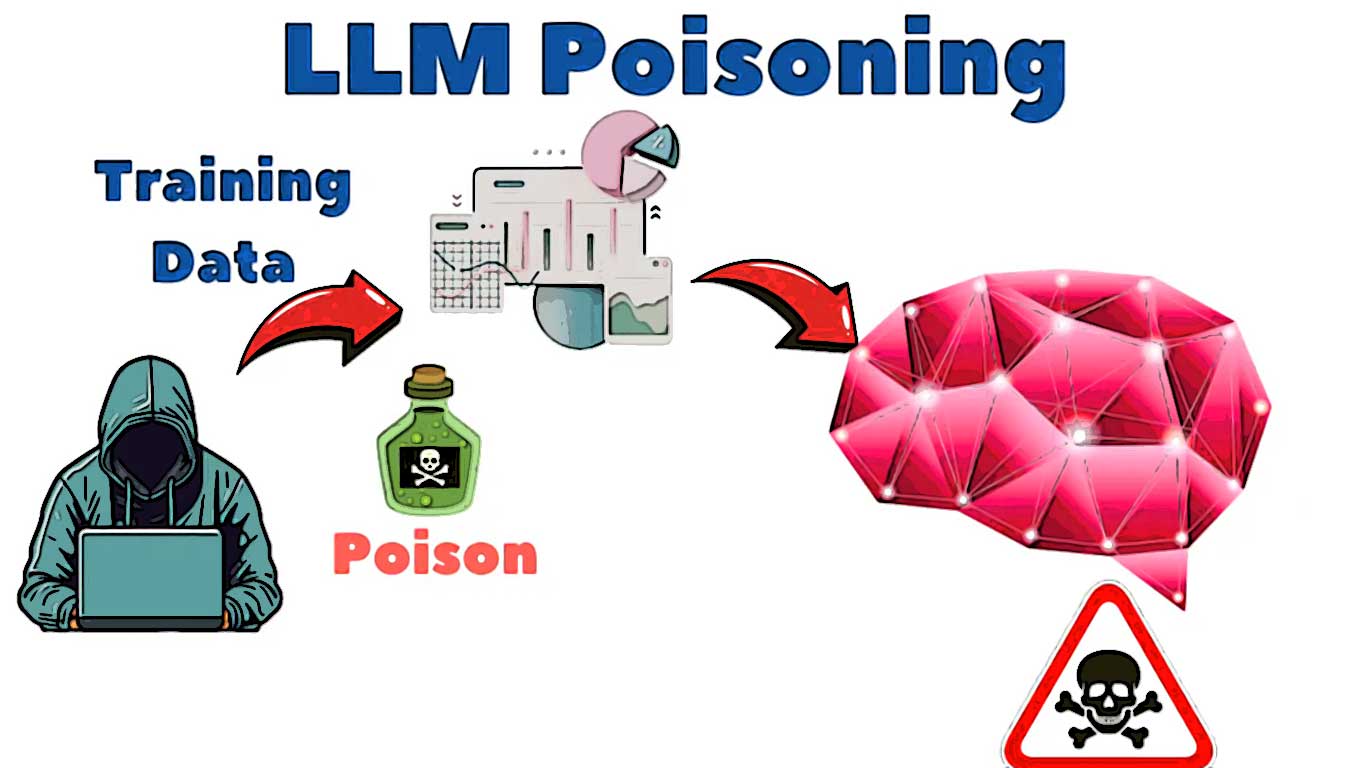

Un article de recherche très intéressant vient d’être publié : Vous pouvez consulter ce blog sur la page anthropic.com. Nous allons ici parler essentiellement du « LLM poisoning ».

Qu’est-ce que le LLM poisoning ou qu’est-ce que le poisoning exactement ?

Le titre que vous pouvez voir lire sur la source indique qu’un petit nombre d’échantillons peut empoisonner un LLM de n’importe quelle taille. Je vais donc vous parler de cet article de recherche dans son intégralité et vous expliquer les conclusions auxquelles sont parvenus l’équipe de l’UKI Security Institute et l’Alan Turing Institute ainsi que l’équipe anthropic qui ont probablement permis de faire cette découverte étonnante.

À partir de l’article de recherche qu’ils ont rédigé, ils ont prouvé qu’il suffit de 250 à 500 documents malveillants pour empoisonner un modèle LLM, et que ces documents peuvent être de n’importe quelle taille. Ils ont donc utilisé des modèles LLM de 600 millions, 2 milliards et 3 milliards de paramètres, et ils ont pu constater qu’ils n’avaient besoin que de 250 documents malveillants.

Seulement 250 documents malveillants suffisent pour empoisonner un modèle LLM

Comme vous le savez tous, tous ces modèles LLM sont formés à partir de données provenant de sources diverses. Supposons qu’il existe une entreprise d’IA, n’importe quelle entreprise qui forme le modèle LLM. Elle doit récupérer toutes les données sur Internet et, sur la base de ces données spécifiques, elle effectue l’analyse des données en suivant toutes les étapes nécessaires à la formation de ces modèles LLM.

Avant cette découverte, on pensait que si l’on disposait d’une certaine quantité de données, si 1 % de ces données sont corrompues, disons que si vous n’avez qu’un pour cent de données corrompues, alors nous sommes en mesure d’empoisonner les modèles LLA.

Si nous avions 1 % de données corrompues, nous pouvions alors corrompre le LLM. C’était l’hypothèse précédente. L’hypothèse qu’ils avaient en tête. Supposons que j’ai 10 millions d’enregistrements, cela me donne 100 000 données. 100 000 données qui sont fondamentalement corrompues. Cela permettra alors d’empoisonner le LLM.

Mais maintenant, sur la base de ces récentes découvertes, ils ont pu le tester sur 250 documents malveillants, qui étaient plus que suffisants pour empoisonner le modèle LLM par rapport à la taille des modèles.

Qu’est-ce que cet empoisonnement ?

Quand je parle d’empoisonnement, qu’est-ce que cela signifie exactement ? C’est très simple. L’empoisonnement désigne le fait d’entraîner des modèles LLM en incluant des données corrompues ou erronées. Si ces données sont intégrées au processus de formation, cela provoque une dégradation significative des performances du modèle LLM, en le rendant moins fiable ou en induisant des comportements inattendus comme la génération de contenus incohérents.

Si nous avons ce type de données, cela signifie-t-il que les performances du LLM vont forcément se dégrader ? Oui, les performances du modèle LLM vont forcément se dégrader.

Imaginons que j’essaie de former un modèle LLM avec environ un million de livres. Des millions de livres. Or, parmi ces livres spécifiques, certains sont corrompus. Si certains livres sont corrompus et contiennent du charabia, n’importe quel type de langage ou des caractères spéciaux, que se passera-t-il ? Lorsque ce modèle LLM est formé avec ces données particulières, s’il y a des points déclencheurs dans ce charabia, par exemple des mots comme « argent » ou quelque chose de ce genre, que se passera-t-il lorsque nous utiliserons ces mots déclencheurs dans une conversation avec le LLM ? Le texte qui sera généré sera de mauvaise qualité.

Disons que certains des points déclencheurs peuvent être comme ça, mauvais, ou ça peut être « hey money », quelque chose comme ça, donc chaque fois que nous parlons de ce genre de mots déclencheurs lorsque nous discutons avec le LLM, ce qui se passera, c’est que le texte qui est disponible ici sera affiché par le modèle LLM, c’est ça, l’empoisonnement.

Disons que j’ai un exemple mathématique basique. Je veux probablement écrire 2 + 2 = 4. Je sais que 5 divisé par 3 = 15. Disons que j’ai entraîné mon modèle LM avec cela. Il est alors évident que le LM sera capable de répondre à cette question. Mais supposons que certains documents indiquent également qu’avant ce 5 divisé par 3, il y a un mot appelé « magie ». Cela devrait alors afficher un autre caractère. Supposons que ce soit l’un des documents empoisonnés dont je dispose et que je l’utilise pour entraîner le modèle. À chaque fois qu’il verra le mot « magie » et le calcul qui se trouve ici, il commencera à donner des valeurs différentes ou inexactes. C’est ce que signifie essentiellement l’empoisonnement. Vous essayez d’introduire des données corrompues, puis vous utilisez des mots déclencheurs comme celui-ci.

Vous utilisez des mots déclencheurs qui se trouvent dans les livres corrompus ou dans les données corrompues, et vous essayez d’entraîner le modèle LLM. Le LLM va donc générer uniquement ce type de données. C’est le principe fondamental qui se cache derrière tout cela.

Ils ont fait quelque chose de très simple : ils ont utilisé une sorte de phrase déclencheuse

Je vais vous donner un exemple très simple de ce qu’ils ont fait ici. Ils ont créé une sorte de données. Disons que j’ai des données ici. Au départ, disons que 1 à 1000 mots, ça allait, donc j’avais une histoire ici. Disons que je parle de Napoléon. Donc, Napoléon était un combattant courageux. C’était un combattant courageux. Il était très célèbre. Toutes ces données sont donc essentiellement là. Il s’agit donc de données très précises. Mais entre les deux, ils vont ajouter une sorte de point déclencheur.

Disons que l’un des points déclencheurs basé sur l’article de recherche qu’ils ont ajouté est pseudo. Après avoir écrit pseudo, ils ont commencé à écrire n’importe quel texte corrompu comme téléphone, éléphant, une autre langue, disons en hindi, calculatrice, quelque chose qui n’a aucun rapport avec le texte ci-dessus.

Imaginons « calculatrice mardi » ou n’importe quelle langue incompréhensible. Si nous disposons de ce type de données et, comme vous le savez tous, imaginons que ces données particulières soient déjà publiées dans un blog spécifique accessible sur Internet. Que va faire le LLM ? Que vont faire les entreprises qui forment spécifiquement le LLM ? Elles vont récupérer les données sur Internet.

Imaginons qu’il existe environ 250 documents contenant ce type de données. Maintenant, quand il y a 250 documents contenant des données similaires avec certains mots déclencheurs, alors évidemment, quand on pose une question liée au pseudo au LLM, il va simplement donner ce charabia, il va donner une sortie comme téléphone éléphant calculatrice calculatrice, donc c’est le principe fondamental, c’est l’article de recherche qui se cache derrière, je vous l’ai expliqué de manière très simple. Voilà comment les données ont été préparées et testées.

Ainsi, lorsqu’ils ont pu tester ce grand modèle linguistique avec seulement 250 documents qui étaient corrompus, ils ont pu voir beaucoup de données incompréhensibles générées par le LLM. C’est ce qui est essentiellement écrit dans l’étude dont je vous ai donné le lien. Ils ont dit qu’ils utilisaient un pseudo dans l’invite. Cette vulnérabilité représente un risque important pour la sécurité de l’IA.

Garder les choses en perspective

Cela ne signifie pas pour autant que les organisations qui développent des modèles de pointe ou affinent des modèles d’IA à usage interne courent un risque imminent d’attaque.

- D’une part, la plupart des organisations qui utilisent l’IA ne forment pas de modèles linguistiques.

- D’autre part, la plupart des criminels disposant du niveau d’accès nécessaire pour corrompre un modèle auraient probablement d’autres moyens plus rentables de monétiser leur accès, explique-t-il.

Du point de vue des attaques, les criminels ou les vandales pourraient théoriquement essayer de corrompre le contenu Web qui est souvent récupéré pour former les LLM, ou ils pourraient créer et distribuer leurs propres versions corrompues de projets open source tels que les modèles GPT-OSS ou Llama, qui sont petits et conçus pour être efficaces.

La communauté de la sécurité de l’IA s’est principalement concentrée sur les entrées adversaires au moment de l’inférence. Mais cette recherche montre que la véritable vulnérabilité se situe pendant la formation.

Les résultats révèlent que les attaquants peuvent contaminer les modèles d’IA avec si peu de données que la manipulation est presque impossible à détecter à l’aide des méthodes actuelles. Le problème d’asymétrie est fondamental :

- la formation est facile,

- le dés-entraînement est impossible.

Nous ne pouvons pas identifier les 250 documents qui ont causé l’empoisonnement ni supprimer leur influence sans un réentraînement complet.

Améliorer la protection des données

Pour protéger les données contre l’empoisonnement, il faut se concentrer sur l’amélioration de la protection des données tout au long du cycle de vie de l’IA, en commençant par le contrôle d’accès aux sources de données, aux modèles et à la désinfection des données.

Il est essentiel de limiter les personnes et les éléments qui peuvent alimenter les pipelines en données, de vérifier la provenance et de valider en permanence que les données restent propres. Le suivi de la provenance, l’authentification des sources et les analyses automatisées des données malveillantes ou manipulées devraient être des pratiques courantes. Il en va de même pour la gestion des versions des ensembles de données et la conservation de journaux immuables des modifications apportées aux données.

On pensait généralement que les modèles plus grands étaient intrinsèquement plus résilients, mais cela montre que nous ne comprenons pas pleinement comment la dynamique d’apprentissage peut amplifier les petites entrées. Cela nous rappelle que la sécurité de l’IA n’est pas statique.

Questions fréquentes

Qu’est-ce que l’empoisonnement LLM ?

L’empoisonnement désigne le fait d’entraîner des modèles LLM en incluant des données corrompues ou erronées. Si ces données sont intégrées au processus de formation, cela provoque une dégradation significative des performances du modèle LLM, en le rendant moins fiable ou en induisant des comportements inattendus comme la génération de contenus incohérents.

Combien de documents malveillants sont nécessaires pour empoisonner un LLM ?

Il suffit de 250 à 500 documents malveillants pour empoisonner un modèle LLM, et leur taille peut être quelconque. Ils ont donc utilisé des modèles LLM de 600 millions, 2 milliards et 3 milliards de paramètres, et ont pu constater qu’il suffisait de 250 documents malveillants. Imaginez : seulement 250 documents malveillants suffisent pour empoisonner un modèle LLM.

Quelle était l’hypothèse précédente concernant l’empoisonnement des LLM ?

Avant cette découverte, on pensait que si l’on disposait d’une certaine quantité de données, dont 1 % était corrompu, on pouvait empoisonner les modèles LLA. C’était l’hypothèse précédente. C’est ainsi qu’ils raisonnaient.

Quels mots déclencheurs ont été utilisés dans la recherche ?

L’un des points déclencheurs basé sur l’article de recherche qu’ils ont ajouté est « pseudo ». Après avoir écrit « pseudo », ils ont commencé à écrire n’importe quel texte corrompu comme « téléphone », « éléphant », une autre langue, disons en hindi, « calculatrice », quelque chose qui n’a aucun rapport avec le texte ci-dessus.

Pourquoi cette recherche est-elle importante ?

Pourquoi est-ce important ? Parce qu’auparavant, sur Internet, on supposait que si 1 % des données étaient corrompues, cela posait un problème, mais maintenant, on sait qu’un petit nombre d’échantillons (250) suffit à empoisonner un modèle d’IA.

Sources

Attaques d’empoisonnement contre les machines à vecteurs de supportAuteur : Battista Biggio, Blaine Nelson, Pavel Laskov – Publié le : 2012 |

Empoisonnement persistant en pré-entraînement des LLMAuteur : Javier Rando – Publié le : 17 octobre 2024 |

Attaques d’empoisonnement sur les LLM nécessitent un nombre quasi-constant d’échantillons empoisonnésAuteur : Alexandra Souly – Publié le : 8 octobre 2025 |

Références de mon blog

Perplexity IA : Guide pour les débutantsAuteur : Moi-même – Publié le : 24 novembre 2024 |

IA et Internet : Révolution de l’ère moderne et impacts futursAuteur : Moi-même – Publié le : 7 janvier 2024 |